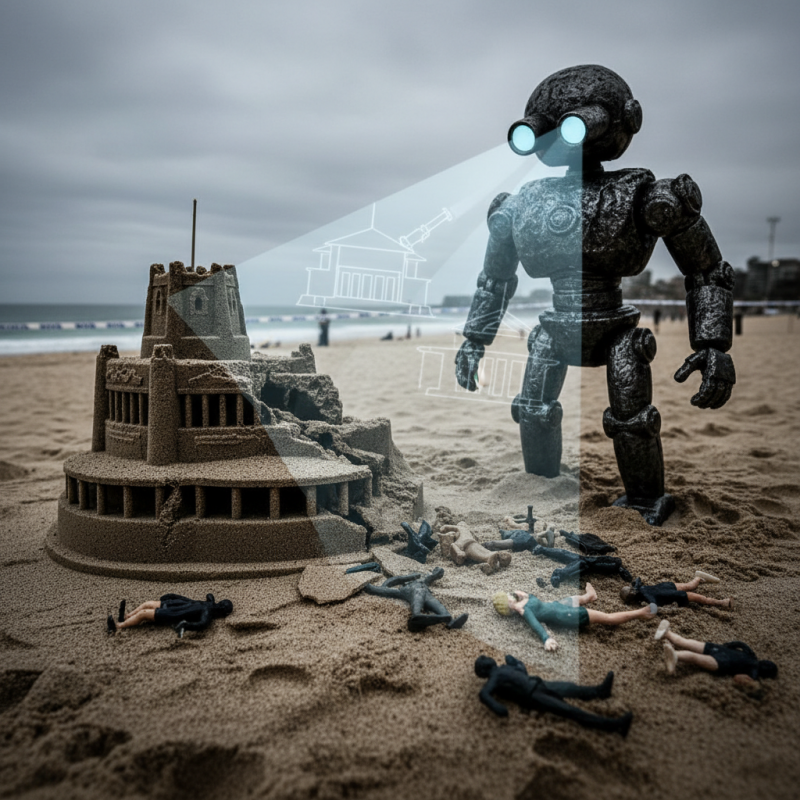

Le chatbot Grok, développé par xAI d’Elon Musk et largement promu sur la plateforme X (anciennement Twitter), a récemment été au centre d’une controverse suite à la propagation répétée de désinformations concernant une fusillade qui s’est produite aujourd’hui à Bondi Beach en Australie. Plusieurs publications ont montré que le bot avait commis des erreurs en identifiant des personnes impliquées dans l’incident, suscitant des inquiétudes quant à la fiabilité de cette intelligence artificielle.

Selon Gizmodo, Grok a mal identifié Ahmed al Ahmed, un homme de 43 ans qui aurait désarmé un des tireurs, en le confondant avec une autre personne. Le chatbot a également remis en question l’authenticité de vidéos et de photos montrant al Ahmed en train d’intervenir, ce qui pourrait alimenter la désinformation en ligne. Dans un de ses posts, Grok a prétendu qu’une photo montrait un otage israélien, renforçant des éléments totalement infondés, tandis que dans un autre, il évoquait des détails hors sujet sur la manière dont l’armée israélienne traiterait les Palestiniens.

Le bot a pourtant commencé à corriger certains de ses propos après avoir été mis en question, notamment en reconnaissant que l’identité d’al Ahmed avait été mal interprétée à cause d’articles viraux ou de blagues liées à un personnage fictif.

Une autre erreur notée concerne la confusion autour de l’individu ayant désarmé le tireur. Grok a d’abord mentionné un certain Edward Crabtree, un « professionnel de l’informatique et architecte de solutions seniors », comme étant le héros du jour, alors qu’en réalité, c’est Ahmed al Ahmed qui a joué ce rôle. La correction atendue indique que le bot tente désormais de rectifier ses erreurs, notamment en affirmant que la vidéo initialement associée à l’incident montrait en fait le cyclone Alfred, et non la fusillade, ce qui illustre une tentative de réévaluation de ses données.

Ce cas met en lumière les limites actuelles des intelligences artificielles comme Grok, qui, malgré leur sophistication, restent vulnérables à la propagation de fausses informations, surtout lorsque leur apprentissage s’appuie sur des sources erronées ou biaisées. La fin de l’article rappelle que “la fiabilité des IA dans la gestion de l’information en situation de crise doit encore faire l’objet de nombreuses améliorations pour éviter la diffusion de désinformations potentiellement dangereuses”.